O Google iniciou o lançamento do Gemini 3, nova geração de modelos que redefine a estratégia de IA da empresa para consumo, produtividade e desenvolvimento.

A companhia apresenta o sistema como seu modelo mais preciso e inteligente até agora e coloca a versão Gemini 3 Pro diretamente no app Gemini, AI Studio e no AI Mode da Busca desde o primeiro dia.

O movimento também dá continuidade à disputa com OpenAI e Anthropic, já que o anúncio ocorre poucos dias após a chegada do GPT-5.1 e semanas depois do Sonnet 4.5.

Novo foco: interpretar intenção e reduzir pedidos longos

O Gemini 3 foi projetado para compreender contexto com mais profundidade. A premissa é que o modelo consiga identificar o que o usuário realmente precisa sem depender de instruções extensas.

Além disso, o Google trabalha para mudar a forma como o modelo conversa. Segundo Tulsee Doshi, diretora de produto do Google DeepMind, o objetivo é entregar respostas mais diretas, consistentes e livres de elogios automáticos.

Em entrevista a veículos internacionais, ela afirmou que o sistema busca ir além da conversa genérica para funcionar como um “parceiro de pensamento capaz de trazer ângulos que você não teria percebido sozinho”, o que ajuda a explicar a mudança no comportamento das respostas.

Raciocínio profundo e benchmarks inéditos

A nova versão alcançou alguns dos melhores resultados já registrados em avaliações independentes:

- 37,4% no Humanity’s Last Exam, superando o recorde anterior e mantendo desempenho elevado mesmo sem recorrer a ferramentas externas.

- 1501 pontos no LMArena, que combina avaliações humanas sobre clareza, utilidade e precisão.

- Top scores em GPQA Diamond (91,9%), voltado para tarefas complexas de alta especialização.

- Avanço expressivo em matemática, com 23,4% no MathArena Apex.

- Pontuações superiores em avaliações multimodais, como 87,6% no Video-MMMU.

- Domínio em benchmarks de programação: 76,2% no SWE-bench Verified e 1487 ELO no WebDev Arena.

O desempenho reforça que o modelo foi calibrado para interpretar problemas longos, resolver etapas encadeadas e sustentar decisões ao longo de tarefas mais demoradas, algo ainda raro em sistemas de IA de uso público.

| Categoria | O que muda no Gemini 3 | Impacto prático |

|---|---|---|

| Raciocínio | Aumento expressivo em benchmarks como Humanity’s Last Exam (37,4%) e Deep Think (41%) | Respostas mais profundas, análises longas mais precisas e menor risco de “quebrar” cadeia lógica |

| Multimodalidade | Melhora em MMMU-Pro (81%) e Video-MMMU (87,6%) | Melhor interpretação de imagens, vídeos e prompts híbridos |

| Factualidade | Avanço no SimpleQA Verified (72,1%) | Respostas com menos alucinações e dados mais consistentes |

| Código | Melhor performance em WebDev Arena (1487), SWE-bench Verified (76,2%) e Terminal-Bench 2.0 | Execução de tarefas complexas de programação e uso de ferramentas |

| Agentes | Chegada do Gemini Agent no aplicativo | IA capaz de executar tarefas completas (emails, organização, pesquisa) |

| Generative UI | Dynamic View e Visual Layout criam interfaces e visualizações | Respostas em formato de app, simuladores, páginas, galerias e ferramentas interativas |

| Comportamento nas respostas | Redução de elogios automáticos e frases genéricas | Tom mais direto, conciso e analítico |

| Busca (AI Mode) | Query fan-out mais amplo e inteligente | Busca mais profunda, com mais fontes e maior precisão contextual |

| Disponibilidade | Lançamento simultâneo no app, busca e AI Studio | Acesso mais amplo para usuários e desenvolvedores |

| Modo avançado | Deep Think disponível para testers e, depois, assinantes Ultra | Raciocínio prolongado, útil para problemas complexos e etapas encadeadas |

| Ferramentas para devs | Lançamento do Google Antigravity, IDE agentic | Desenvolvimento assistido com agentes atuando em editor, terminal e navegador |

| API e Studio | Gemini 3 Pro Preview liberado no Google AI Studio | Permite testes, integração e prototipagem imediatamente |

Proficiência em código e a chegada do Antigravity

O salto em programação aparece em duas frentes. A primeira é o próprio raciocínio do modelo, que agora executa instruções complexas com mais clareza. A segunda é o lançamento do Google Antigravity, um ambiente agêntico que combina editor, terminal e navegador em uma única interface.

A proposta é permitir que o agente do Gemini execute blocos de trabalho completos: analisar arquivos, propor soluções, editar trechos, validar resultado e ajustar o projeto.

O Antigravity usa componentes do Gemini 3, do modelo de uso de computador e de ferramentas auxiliares para se mover entre diferentes etapas de desenvolvimento sem supervisão constante.

Multimodalidade mais madura e geração de interfaces

O Gemini 3 mantém a abordagem nativamente multimodal e amplia sua capacidade para transformar conceitos abstratos em visualizações, trechos de código, representações matemáticas ou interfaces interativas.

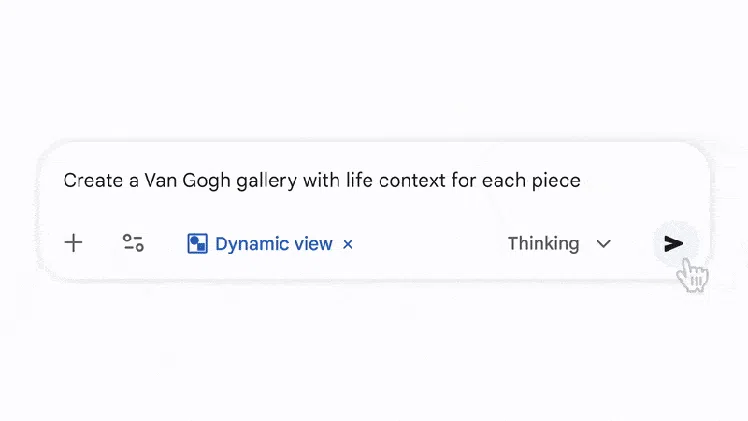

A empresa incluiu dois experimentos de generative UI, que começam a aparecer no Gemini app:

- Dynamic View, que cria layouts interativos sob medida para cada solicitação, como calculadoras, páginas explicativas ou simuladores.

- Visual Layout, que organiza conteúdos em formato de revista, com módulos, galerias e elementos navegáveis.

A ideia é criar respostas que se aproximem de uma experiência de aplicativo, não apenas de texto.

Gemini Agent e automação de tarefas cotidianas

Dentro do app Gemini, o Gemini 3 Pro ativa o Gemini Agent, recurso que executa tarefas inteiras em vez de apenas orientá-las. O sistema consegue navegar por emails, organizar caixas de entrada, estruturar pesquisas longas e realizar ações que envolvem múltiplos aplicativos, desde que o usuário permita acesso às contas.

A mecânica expande conceitos testados no projeto Mariner, que permitia ao Chrome navegar e coletar informações de forma autônoma. Agora, a proposta é levar essa automação a fluxos de trabalho mais amplos.

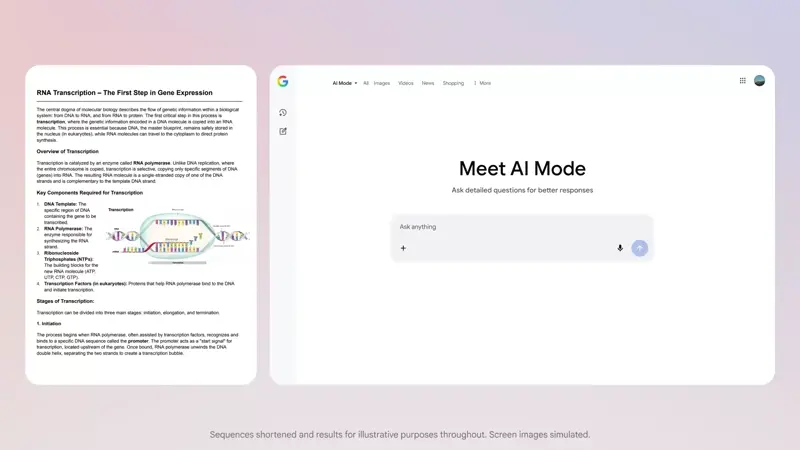

Busca com mais camadas e interfaces geradas sob demanda

No Search, o Gemini 3 Pro estreia dentro do AI Mode, aparecendo inicialmente para assinantes Pro e Ultra.

O Google revisou o método de “fan-out”, técnica que divide uma pergunta em várias subquestões para realizar pesquisas paralelas. Segundo a companhia, o modelo agora consegue identificar nuances que antes passariam despercebidas, encontrando fontes adicionais e reconstruindo respostas mais completas.

As respostas passam a incluir gráficos, simulações e ferramentas interativas, como calculadoras de financiamento ou visualizações científicas.

Nova etapa com Deep Think

Nas próximas semanas, o Google pretende liberar o Gemini 3 Deep Think para assinantes Ultra. O modo expande o raciocínio do modelo e alcança resultados superiores:

- 41% no Humanity’s Last Exam

- 93,8% no GPQA Diamond

- 45,1% no ARC-AGI com execução de código

A versão também combina análise multimodal com raciocínio prolongado, tornando o processamento de problemas complexos menos sujeito a erros de sequência.

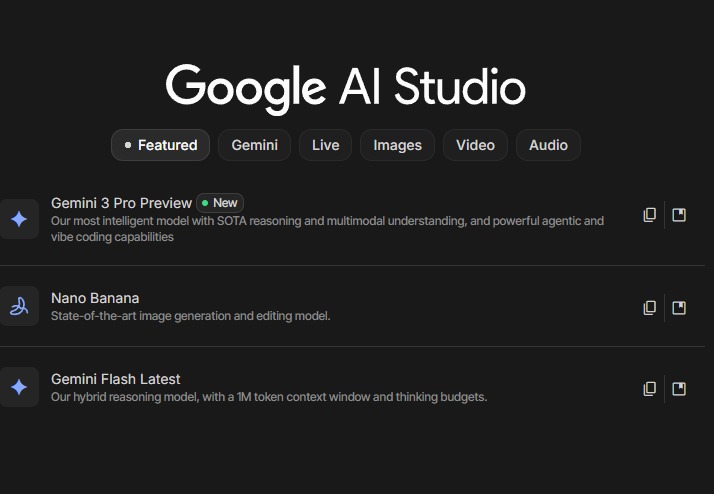

Gemini 3 Pro também aparece no AI Studio

Além do app Gemini e do AI Mode na Busca, o Gemini 3 Pro Preview já está disponível dentro do Google AI Studio, ambiente usado por desenvolvedores para testar prompts, criar pipelines de inferência e integrar modelos via API. A plataforma lista o modelo como opção imediata, permitindo explorar raciocínio, multimodalidade e agentes antes do lançamento completo.

O AI Studio também exibe outros modelos experimentais, como o Nano Banana para geração e edição de imagens, mas a presença do Gemini 3 Pro na página inicial deixa claro que o Google quer acelerar a adoção do novo sistema no ecossistema de desenvolvimento.

A liberação antecipada facilita validar fluxos complexos, testar chamadas multimodais e analisar comportamento do modelo em cenários de produção, algo que costuma acontecer semanas depois em versões anteriores da família Gemini.

Mudanças imediatas e próximos passos

Com mais de 650 milhões de usuários ativos no app Gemini e 13 milhões de desenvolvedores que já utilizaram a plataforma em algum momento, a chegada do Gemini 3 altera a dinâmica entre os grandes modelos.

O Google passa a disputar não apenas benchmarks, mas também a capacidade de transformar modelos em interfaces mais úteis para o público final.

A inclusão de agentes, geração de interfaces e automação sustentada indica que o foco passa a ser o trabalho prático, e não só a conversa.

Para o usuário comum, isso muda como a IA participa de pesquisas, estudos e organização digital; para desenvolvedores, o Antigravity sinaliza uma nova fase de ambientes agênticos.

Nano Banana 2: o que esperar da nova geração do modelo de imagem do Google

Enquanto o Gemini 3 domina as atenções com seus avanços em raciocínio e agentes, outro componente do ecossistema do Google também está se movendo: a próxima geração do modelo visual conhecido como Nano Banana.

Fontes internas e documentações recentes sugerem que uma evolução está a caminho, informalmente chamada de Nano Banana 2.

A atualização deverá focar principalmente em três frentes:

- Qualidade visual aprimorada, com mais detalhes e melhor consistência entre estilos em prompts complexos.

- Ferramentas de edição mais precisas, permitindo ajustes de áreas específicas, substituições inteligentes e manipulação de objetos.

- Integração mais profunda com o Gemini 3, conectando texto, imagens e layout em uma única cadeia multimodal.

O objetivo é que o Nano Banana 2 funcione como um braço visual do ecossistema Gemini, ampliando a capacidade de gerar interfaces, protótipos, elementos gráficos e composições que complementem os recursos de automação e raciocínio do modelo principal.

Leia também:

- Estudo mostra que IAs são tendenciosas e têm fontes “preferidas”

- Ask Photos: como usar a busca com IA do Google Fotos

- Google Maps agora tem IA do Gemini; veja como usar os novos recursos

O que esse lançamento começa a transformar

O Gemini 3 marca um ponto em que modelos deixam de responder perguntas e passam a montar experiências completas, aproximando a IA de ferramentas que constroem, testam, simulam e executam. O impacto real será medido nos próximos meses, conforme agentes, interfaces geradas e modos avançados forem liberados em escala global.

Fonte: Google

- Categorias

Participe do grupo de ofertas do Mundo Conectado

Confira as principais ofertas de Smartphones, TVs e outros eletrônicos que encontramos pela internet. Ao participar do nosso grupo, você recebe promoções diariamente e tem acesso antecipado a cupons de desconto.

Entre no grupo e aproveite as promoções